芯片干戈新念念路:用英伟达的样子,抗衡英伟达

- 发布日期:2024-06-09 21:34 点击次数:188

作家|王艺

裁剪|王博

6月6日,英伟达市值达到了3.01万亿好意思元,向上苹果成为全球市值第二高的公司,仅次于微软。

而客岁此时,英伟达的市值刚刚龙套万亿好意思元,成为好意思国第七个,亦然史上第九个置身万亿市值俱乐部的科技公司。

当年的曹阿瞒,如今已成为了曹丞相。

“范畴达3万亿好意思元的IT行业,行将打造的商品能够直接处事于100万亿好意思元的其他行业。这个商品不再只是是信息存储或数据处理器具,而是一个能为各个行业生成智能的工场。”英伟达创举东谈主兼CEO黄仁勋6月2日在Computex 2024(2024台北海外电脑展)上发表主题演讲时志空隙满。

在生成式AI时期,英伟达的生效无需赘述。尽管台下站满了挑战者,包括老敌手英特尔、AMD,大厂华为、谷歌、微软,以及国内独角兽摩尔线程、寒武纪、壁仞科技等,时时还有英伟达的“间隙”“破绽”瓜分析著述,挑战者不可谓不彊,分析也不是莫得兴味,但英伟达的市值施展了一切。

然则,这并不料味着其它芯片厂商就莫得契机,关节是要找到合适的门径。

靠近堪称领有的八十万雄兵的曹操,江东群儒民怨兴盛,以致有东谈主喊出:“曹操虽挟皇帝以令诸侯,犹是相国曹参之后。刘豫州虽云中山靖王苗裔,却无可稽考,目击只是织席贩屦之夫耳,何足与曹操抗衡哉!”

靠近强势的英伟达,国内自惭形愧之声也不少,就像当年的江东群儒一样。

但也有东谈主在念念考“破曹之策”。曹操此前取得官渡之战,来自乌巢的一场火。而赤壁之战前,诸葛亮和周瑜写在手心的领悟亦然“火”。

用英伟达蚕食英特尔市集的样子,来与英伟达抗衡,等于芯片厂商欲燃起的“火”。

1.改变CPU依赖

上世纪80到90年代,是英特尔终点x86架构主导的年代。

x86架构始于1978年,那时英特尔公司推出了16位微处理器8086。由于以“86”当作驱逐,因此其架构被称为x86。

到了1997年,全球向上90%的个东谈主电脑和数据中心都搭载了英特尔的CPU(中央处理器),狡计机里面大部分的互联条约、接口要领、芯片组和主板要领、内存要领、网罗要领等,都是由英特尔界说的。

阿谁年代,还有不少公司也在开导CPU这种推论输入狡计机的敕令的通用芯片。不外,上世纪90年代初,SunSoft公司有三位工程师(两位工程师、一位合作工程师)被请托构建一种不错与CPU一王人插入SunSoft职责站并不错在屏幕上渲染图形的芯片。

这款芯片被以为是英伟达GPU(图形处理器)的前身,而这三个东谈主是克里斯·马拉科夫斯基(Chris Malachowsky)、柯蒂斯·普里姆(Curtis Priem)和黄仁勋。

1993年,他们三个东谈主共同创立了英伟达,他们并莫得选拔研发CPU直接与英特尔竞争,而是选拔入局基于图形和视频游戏的狡计卡市集。

尽管英伟达首款居品NV1卖得并不好,然则1997年其推出的128位3D处理器RIVA 128在四个月内出货量龙套100万台;1999年推出的GeForce 256更是成为了那时的爆款居品,图形狡计卡也因此有了一个新的名字——GPU。

GeForce256的改造性龙套在于T&L引擎(Transforming&Lighting,坐标升沉和光照狡计)的加入,这使得显卡能够进行多量浮点运算,并将蓝本依赖CPU的3D狡计剥离到显卡上,从而开释了多量CPU资源。这让游戏运行更通顺的同期,也大幅提高了画面的良好度。

因此,GeForce256直接改变了业内的竞争景观,之前用“高端CPU”才能完成的职责,酿成了用“惯例CPU+GeForce256”就能完成,而且通顺度更好。

这意味着,一部分用户对CPU的依赖,逐步转到了对GPU的依赖。

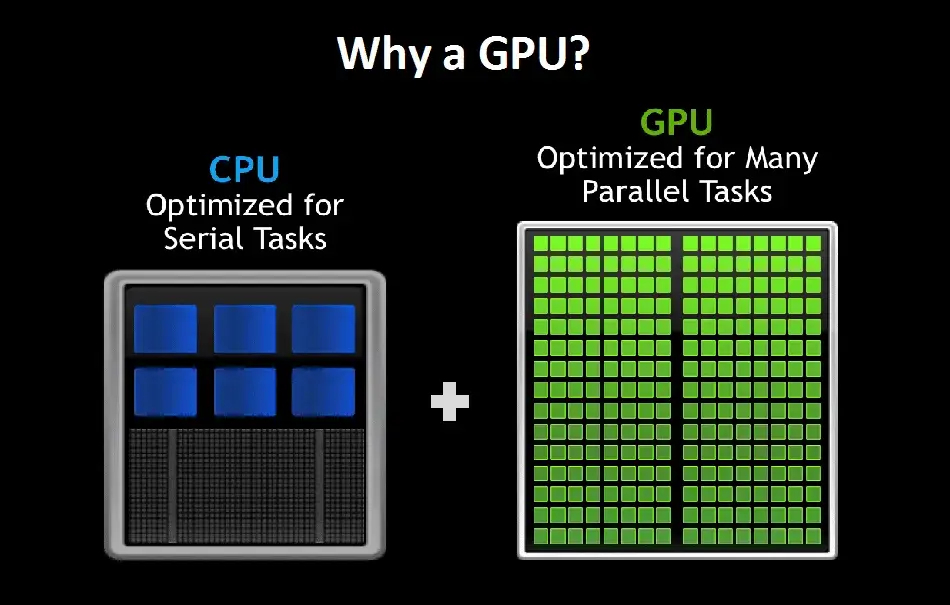

CPU和GPU是狡计机中两种不同类型的处理器,CPU假想用于推论芜俚的狡计任务,荒谬是限定处理和复杂逻辑,领有较少但功能康健的中枢;而GPU则专为处理多量并行狡计任务而假想,如图形渲染和视频处理,领有多量但功能相对爽朗的中枢,使得GPU在处理多线程和数据密集型任务时更为高效。

英伟达最初假想GPU是为了给《光环》和《侠盗猎车手》等热点的电子游戏快速渲染图形,但在这个进程中,深度学习的有计划东谈主员意志到,GPU相同擅长运行撑握神经网罗的数学。基于这些芯片,神经网罗能够在更短的时期内从更多的数据中进行学习。

2006年,英伟达推出CUDA(Compute Unified Device Architecture,挽救狡计架构),极地面简化了并行编程的复杂性,使得开导者能够随意地为装有GPU的电脑编程,让电脑不仅能够处理图形假想任务,还能够进行高效的数据运算。现实上,这样的电脑在性能上仍是绝顶于一个超等狡计机,成本却大大裁减,这使得高性能狡计变得愈加普及。

2009年深秋,一位六十多岁的学者从加拿大多伦多来到好意思国西雅图,由于腰椎间盘有伤,他简直无法弯腰或坐着,只可躺着或站着,但他如故坚握和当地微软实验室的同仁开启了一个样子——专揽之前的有计划遵守打造一个原型,练习一个神经网罗来识别白话词汇。

这位学者等于多伦多大学狡计机科学系训诫杰弗里·辛顿(Geoffrey Hinton),在这个样子中,他们就使用了英伟达的GPU。在样子组里的东谈主以为GPU是用来玩游戏的,而不是用来作念东谈主工智能有计划的时候,辛顿那时直言,如果莫得一套王人备不同的硬件,包括一块价值一万好意思元的GPU显卡,这个样子就不会生效。

2012年10月,辛顿和他的两名学生——亚历克斯·克里哲夫斯基(Alex Krizhevsky)、伊利亚·苏茨克维(Ilya Sutskever),在ImageNet图像识别比赛上拿了冠军,况且发表论文先容了AlexNet架构,而他们练习这种全新的深度卷积神经网罗架构仅用了两块英伟达GPU。

AlexNet团队参赛的时候发现,如果用CPU来练习AlexNet需要几个月的时期,于是他们尝试了一下英伟达的GPU,没料想用两张GTX 580显卡只花了一周的时期就完成了1400万张图片的练习。这场比赛不仅加速了神经网罗有计划的发展,更是让GPU进入了更多AI有计划者、工程师的视线——很快,互联网公司和高校实验室就初始向英伟达订购GPU。

英伟达当然也意志到了GPU关于AI加速狡计的紧要性,并初始把稳布局专门用于AI练习的GPU居品。2016年,黄仁勋向OpenAI捐赠了首台DGX-1,并在上头写到:To Elon & the OpenAI Team! To the future of computing and humanity. I present you the World's First DGX-1!(致埃隆和OpenAI团队!致狡计和东谈主类的改日。我为你们呈上寰宇上首台DGX-1!)

六年后,OpenAI的ChatGPT掀翻大模子海浪,开启了对算力的新一轮困难需求;后头的故事环球都知谈了——英伟达的GPU和数据中心迎超刚毅爆发,一年内利润暴涨8倍,一卡难求。

而英特尔,逐步被英伟达甩开了。

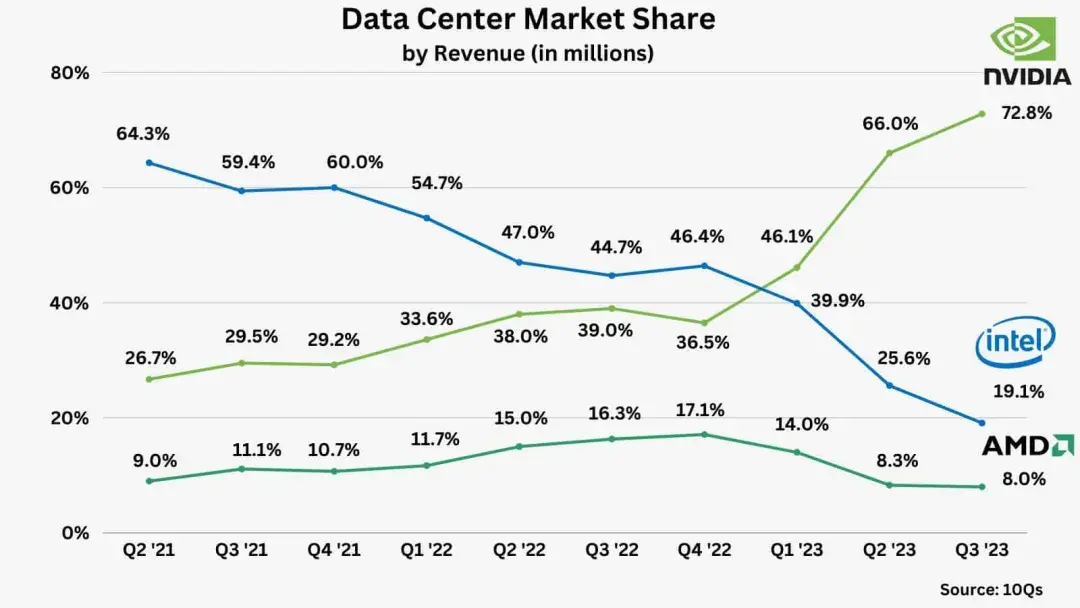

把柄Counterpoint的数据,2022年Q4英特尔的数据中心还有46.4%的市集份额,然则由于在AI芯片边界的竞争力不及,2023年Q3其市集份额降至19.1%;而英伟达数据中心的市集份额则一齐走高,从2022年Q4的36.5%增长到2023年Q3的72.8%。

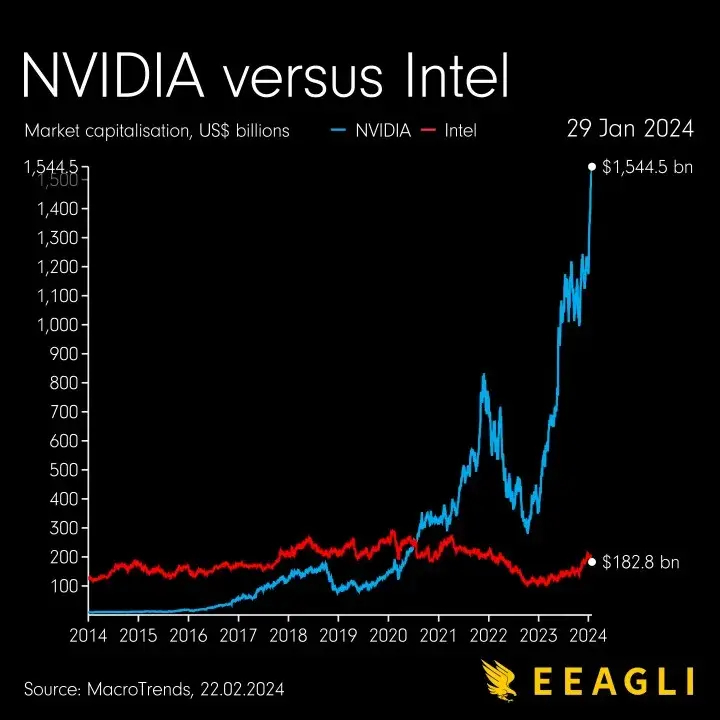

如今,英伟达是AI边界绕不外去的名字。四年前,当27岁的英伟达市值初次向上英特尔时,这被看作“一个时期的终结”。而到了本年6月6日,当英伟达市值达到3.01万亿好意思元时,其市值已是英特尔的23倍。

英伟达卓绝英特尔并不是研发出了比英特尔更强的CPU,也不是强行新建生态,而是先融入到英特尔的生态中,再专揽其特殊上风,对准GPU进行单点龙套,让用户逐步减少对CPU的依赖,转而加强对GPU的依赖,最终确立我方的生态。

最终的结果是,由于需求的减少,CPU的迭代速率变慢,而GPU的迭代速率在加速。

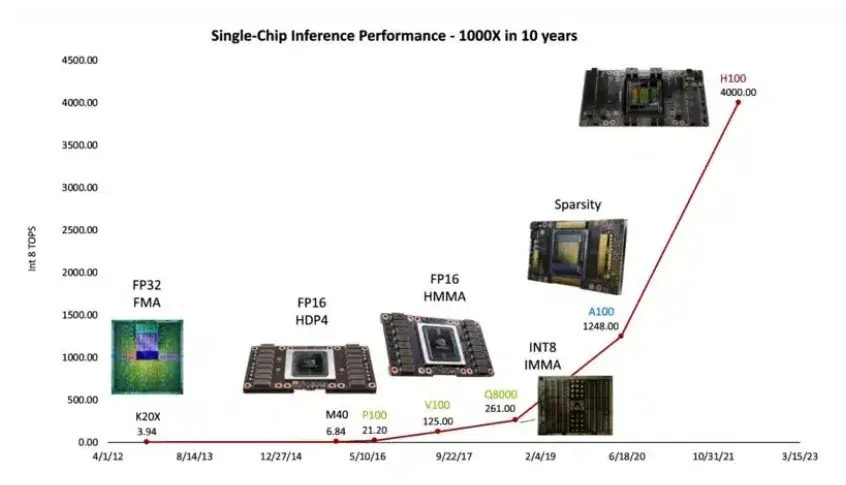

客岁,英伟达发文晓喻了“黄氏定律(Huang's Law)”,该定律展望GPU将鼓动AI性能完结逐年翻倍。与摩尔定律照应于晶体管数目的翻倍不同,黄氏定律把稳于GPU在AI处理能力方面的增长。在夙昔十年中,英伟达GPU的东谈主工智能处理能力增长了1000倍。

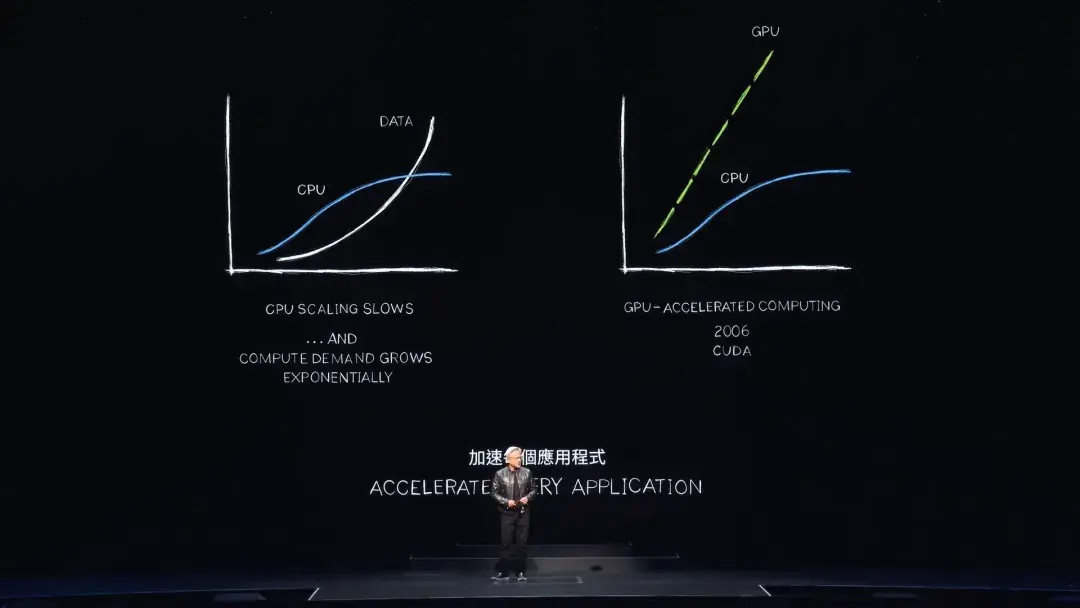

黄仁勋在Computex 2024的主题演讲中特地晒出了CPU和GPU的对比图,并示意,CPU性能的蔓延速率无法再跟上数据握续呈指数级增长的速率,但还有一个更好的办法等于加速狡计。

“CUDA增强了(蓝本由)CPU(提供的狡计能力),卸载的同期加速了更合适由专用处理器处理的职责负载。事实上,性能擢升十分显贵,跟着CPU蔓延速率放慢并最终基本住手,谜底无庸赘述,加速狡计才是处治之谈。”黄仁勋说。

如果要用一个词总结英伟达的吩咐,那等于“异构”。

英伟达所作念的“异构”,等于把算力的提供方从CPU,酿成CPU+GPU。这种创新架构带来的性能擢升是惊东谈主的,加速100倍,而功率仅加多约3倍,成本仅飞腾约50%。“咱们在PC行业早已实践了这种计策。在数据中心,咱们也接受了相同的门径。”黄仁勋说。

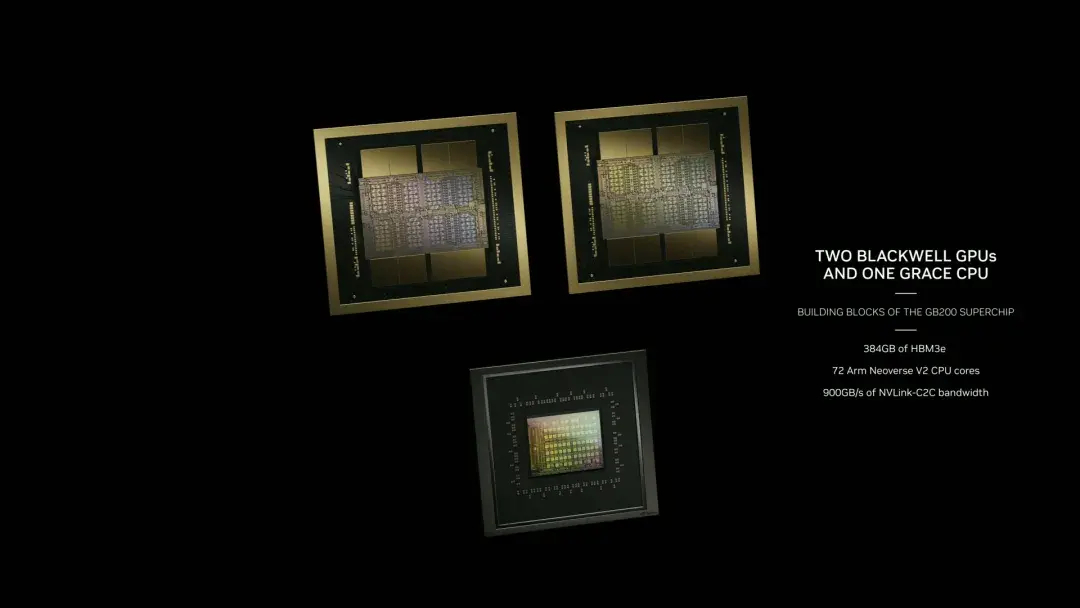

英伟达在本年GTC推出的GB200超等芯片等于由两张B200 Blackwell GPU和一张Grace CPU组成。这种组合提供了康健的推理能力,荒谬是在处理谎言语模子时,推感性能比H100擢升了30倍,成本和能耗降至原来的1/25。

英伟达卓绝英特尔,不是一个新的CPU的故事,也不是GPU取代了CPU的故事,而是CPU+GPU异构的硬件形态逐步地取代了CPU集群的故事。

英伟达的吩咐,对如今的AI芯片公司有很大的鉴戒道理道理——跟巨头竞争,不错不走“替代”的逻辑,而是进行“配比”的艺术,在原有的游戏规则下把单点拉满,贵金属交易拉到原有霸主追不上,进而蔓延我方的生态位。

那么,新的单点是什么呢?

2.寻找新的单点

当今算力行业的痛点是,英伟达的芯片太贵、供不应求,关于国内用户来说,还要加上高性能芯片无法通过正当渠谈买到这一条。

尽管其它芯片厂家也在追逐英伟达,推出多样AI芯片。然则,某芯片厂商大模子巨匠陈风(假名)告诉「甲子光年」,想要擢升算力,必须在软件和硬件两方面同步发力,而英伟达的CUDA和其硬件的适配体系作念得太好,以至于在算力专揽率上,其他厂商很难望其肩背。

“就以AMD为例,单卡算力是383TFLOPs,仍是比英伟达的某些卡要高了,然则算力的专揽率等于比英伟达低,为什么呢?因为软件莫得办法充分进展硬件的性能。环球都能作念7纳米又怎样?你即使是用7纳米的芯片,算力专揽率也作念不外英伟达320TFLOPs的GPU。”陈风说。

不外英伟达的这种算力集群,亦然范畴不经济的。如今,大模子辽远的角落成本也仍是成为其买卖化最大的波折。红杉成本透露,AI行业客岁仅在英伟达芯片上就破耗了500亿好意思元,但产出的营收惟有30亿好意思元,干涉产出比为17:1。

有芯片厂商意志到,英伟达的好和贵,是把自家单卡居品叠叠罗汉、加上NVLink、NVSwitch和Infiniband等互联技艺和CUDA平台,组成一个顽固的体系完结的。如果参考英伟达卓绝英特尔的样子,不跟英伟达硬拼“CPU+GPU”,而是去找一个新单点,用“CPU+GPU+新单点”的体系,冉冉侵蚀掉英伟达顽固不菲的旧体系,是不是就能把价钱打下来,同期解构掉英伟达原来的上风地位了呢?

那么,这个新单点是什么呢?

把眼神放到需求端,一切似乎都有了谜底。

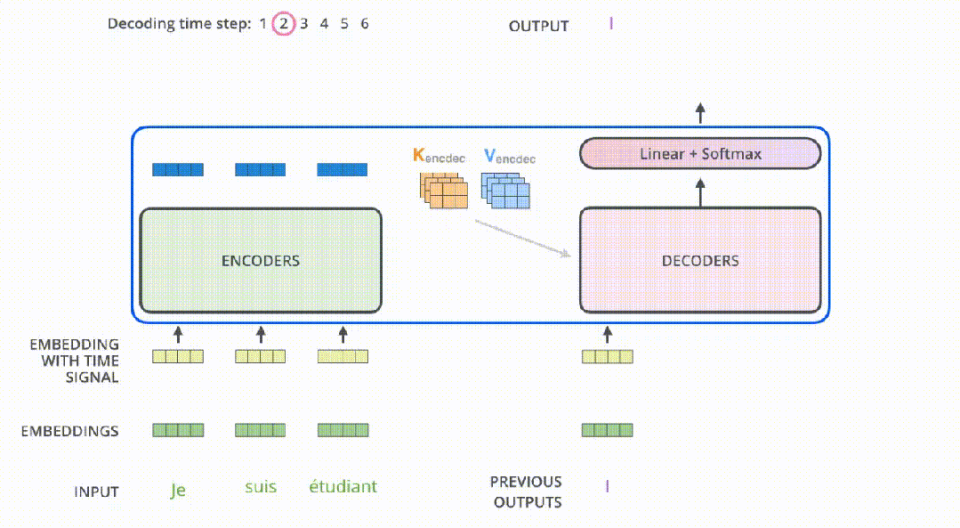

目下,以GPT为代表的大模子主如果Transformer架构,这一架构的特色等于绝顶吃显存。

这不单是因为Transformer模子频繁包含多量的权重参数,更是因为自追思算法让Transformer模子在处理序列数据时,每加多一个输入序列的长度,就需要更多的显存来存储该序列的镶嵌向量、键(key)、查询(query)和值(value)向量,以及中间狡计的荫藏气象,荒谬是自把稳力机制的狡计复杂度还与序列长度的平常成正比;同期,Transformer每层都会产生多量的激活张量,这些张量在反向传播期间用于狡计梯度,也需要暂存在显存中……各样身分,导致跟着输入序列长度的增长,显存占用连忙飞腾。

针对大模子推理这类访存密集型的任务,显存终点带宽会彰着放弃其对算力的专揽,因此在有计划算力需求的时候,似乎也不成单单有计划FLOPs的需求,显存容量及带宽相同紧要。

在大模子的游戏规则下,显存容量、显存带宽以及互联带宽酿成了最中枢的竞争力,而算力的紧要性和优先级则在肃静向后排。

作念一张“显存假想很高的新式狡计卡”等于新的单点,这就给其它芯片厂商提供了一个和英伟达竞争的新念念路——向着显存,全速前进。

3.斗胆假定,防卫求证

季宇等于这样想的,当作英伟达的粉丝,他但愿用英伟达的样子卓绝英伟达,也因此将眼神聚焦在了大模子对显存的需求上。

季宇毕业于清华大学狡计机系,博士期间一直专注于神经网罗加速器、编译器和面向系统优化的机器学习的有计划,毕业后当作华为“天才少年”在海念念从事昇腾编译器架构师联系职责。2023年8月,他创立了行云集成电路,主要致力于于于研发下一代针对大模子场景的AI加速狡计芯片。

具体来说,行云集成电路但愿作念一张“显存假想很高的新式狡计卡”,通过”CPU+GPU+新式狡计卡”的组合,去支吾大模子推理时访存密集的多样任务,进而把“显存”这一单点拉满,成为与英伟达体系相抗衡的存在。

“大模子有辽远的显存需求是业界的共鸣。在英伟达也在不休擢升GPU的显存规格来空隙市集需求,但咱们但愿用两张卡,也等于一张算力密集的卡、一张访存密集的卡来处治这个问题。两张卡的决策里面,算力密集的那张卡以致不错是英伟达的GPU。”季宇说。

季宇也荒谬贯注“异构”,“不外我讲的‘异构’是雷同夙昔CPU和GPU这种不同居品生态位的异构,今天算力行业说得好多的‘异构’是指吞并个芯片生态位下不同芯片的异构,比如不同的AI芯片”。行云集成电路的定位是一家芯片厂商,而非算力运营商,“咱们是卖卡,英伟达和处事器厂商什么关系,咱们就和处事器厂商什么关系”。

关于生态,季宇以为任何茁壮的产业都需要一个绽放的生态体系,也等于一个“白盒”,大模子产业也不例外。但英伟达是一个顽固的体系,把算力、内存、互联等各项要领都作念得很强,导致我方的黑盒体系越来越有竞争力、也越来越顽固。

“今天有太多公司为了跟英伟达的这套体系竞争,既要作念单卡、又要作念互联、处事器、网罗,自建和英伟达对看法特有体系干涉辽远,也极其困难,如果能给业界塑造一个可蔓延的白盒体系,让体系内的参与者在每个维度与英伟达充分竞争,把英伟达的这套特有体系的力量打散,好像能有与英伟达体系博弈的契机。”季宇告诉「甲子光年」,“虽然英伟达也不错在每个维度作念到相当最初,只是它的溢价一定会被越来越强的同业给稀释收场。”

不外季宇也坦言,目下居品还没出来,一些假定也有待论证。目下最紧要的是诱惑更多志同谈合的东谈主才、合作伙伴,沉静作念好研发职责。

恒久照应半导体行业的新鼎成本结伴东谈主以为,这种新的AI芯片竞争念念路不错更好地空隙不同的应用需求,在某些特定的场景下会产生更好的效果和性价比。“这种决策真实很有启发性,然则也有困难和风险,触及到各个厂商之间的高度的配合和和洽,也触及到技艺假想、利润分派等多样复杂的问题,需要在研发进程当中,不休的适配新场景,不休的探索和优化。”

鲁民投上海投资总监杨浩也示意,这种联合全行业作念白盒生态的念念路相当新颖,“当今环球都想挑战英伟达,然则如实生态跟不上,国内惟有少部分公司在作念。如果能通过新式居品掀开龙套口,确立一个新的生态的话,远景如实值得期待。”

关联词,在国内某芯片初创公司工程师刘永(假名)看来,行云集成电路提议的新念念路,还有待盘问。

“目下主流扩显存的样子是在一张卡里把GPU和HBM的配比作念到平衡,然后专揽片间互连的样子,将多张这样的卡连络洽,共同为大模子提供处事。这种样子能够完结显存的蔓延,也不错充分专揽其他卡的算力资源,完结并行狡计,同期高效的数据交换和同步。”刘永说。

刘永以为,行云集成电路真实提议了一种新颖的假想样子,不错显贵蔓延可用显存容量,从而能够处理更大范畴的模子和数据集,卓绝单卡显存容量的放弃,在大显存卡上可能会颠覆现存的存储端倪结构(多级cache+HBM的决策),假想可能会更爽朗,也有更多面积不错用到HBM上,成本更低、容量更大。

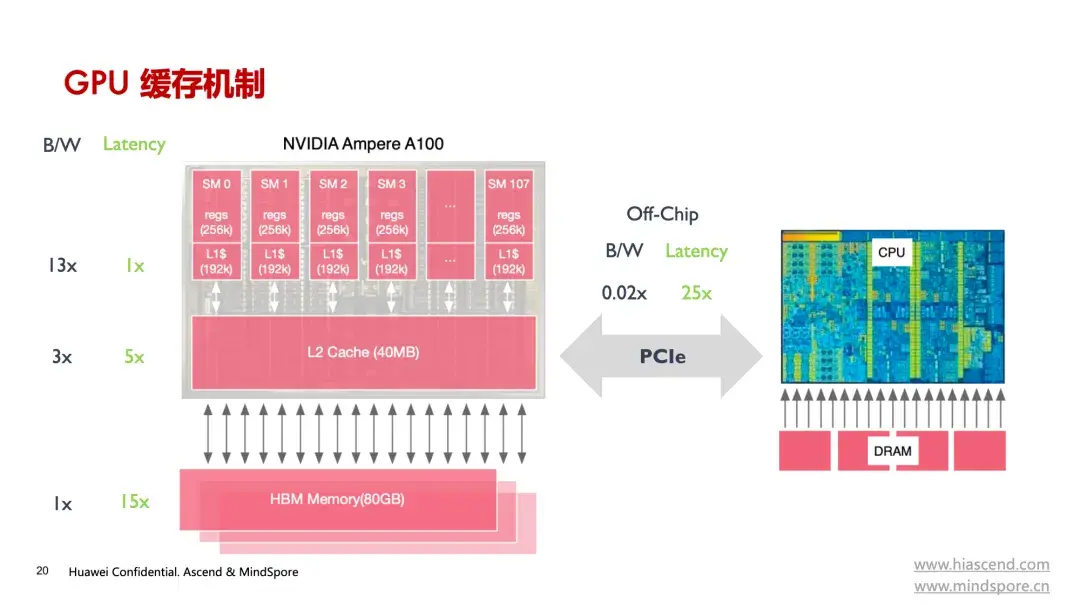

刘永提到的HBM(High Bandwidth Memory,高带宽内存)是一种先进的存储技艺,专为需要多量数据费解量的应用场景假想,相当合适用于AI加速狡计,HBM亦然制约单芯片能力的最大瓶颈之一。

HBM将多个DRAM芯片通过硅中介层(interposer)堆叠在一王人,并直接接洽到GPU或其他处理器,而不是像传统内存那样通过主板上的内存插槽接洽。由于每个DRAM层都能够通过短路平直接与处理器通讯,减少了数据传输的蔓延,因此HBM的这种三维堆叠结构极大提高了显存容量和能力。

但HBM技艺触及到先进封装工艺,亦然国内被外部放弃的边界,想靠HBM扩大显存,阻力重重。

“HBM的成本简直占据了一张芯片成本的50%,而且当今国内能作念HBM的企业未几,惟有长鑫存储,然则长鑫存储的工艺较之台积电、日蟾光如故过期少许。HBM3E(最新一代HBM)还在流片进程中且质料不沉静,而英伟达Blackwell架构的GPU B100仍是用上HBM3E了。”昇腾大模子练习巨匠、B站AI科普视频UP主ZOMI酱告诉「甲子光年」。

由此看来,大模子和GPU是明战,HBM则是暗战。

甲子光年智库以为,AI坐蓐时期,算力是坐蓐力的压舱石。这里面最大的命题是,要处治算力供需结构的矛盾。悉数这个词“算力江湖”的组成是极其复杂和多元的,并不存在一个能够统治全局的“铁王座”。

虽说技艺对芯片至关紧要,但芯片更需要的是市集。

英伟达用一种样子卓绝了英特尔,谁能说不会出现新的挑战者,用英伟达的样子与英伟达抗衡呢?

“东风不与周郎便,铜雀春深锁二乔。”在芯片的“干戈”中,不少芯片厂商如同江东的将士们一样,仍是作念好了准备,“只待风来”。

- 好意思国科技大佬傻眼了:东大芯片强到什么地步?咱们根蒂不知谈他们还能掏出啥王炸!_中国_手艺_东谈主家2025-08-18

- 国内首款、自主教导,搭载龙芯2P0500主控芯片的极印打印机量产出货2024-09-30

- 多家芯片厂为了保命,加价2024-05-12

- 不殉国算法,不抉剔芯片,这个来自中科院的团队正在加速国产AI芯片破局2024-04-10